Yapay sinir ağı - Artificial neural network

| Bir dizinin parçası |

| Makine öğrenme ve veri madenciliği |

|---|

Makine öğrenimi mekanları |

| Bir dizinin parçası |

| Yapay zeka |

|---|

Sözlük |

|

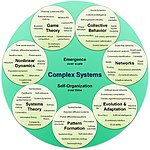

| Karmaşık sistemler |

|---|

| Konular |

| Ağ bilimi | ||||

|---|---|---|---|---|

| Ağ türleri | ||||

| Grafikler | ||||

| ||||

| Modeller | ||||

| ||||

| ||||

| ||||

Yapay sinir ağları (YSA'lar), genellikle basitçe denir nöral ağlar (NN'ler), bilgi işlem sistemleri biyolojik sinir ağları hayvanı oluşturan beyinler.[1]

YSA, adı verilen bağlı birimler veya düğümler koleksiyonuna dayanır. yapay nöronlar gevşek bir şekilde modelleyen nöronlar biyolojik bir beyinde. Her bağlantı, tıpkı sinapslar biyolojik bir beyinde, diğer nöronlara bir sinyal iletebilir. Bir sinyal alan yapay bir nöron, onu işler ve ona bağlı nöronlara sinyal gönderebilir. Bir bağlantıdaki "sinyal" bir gerçek Numara ve her nöronun çıktısı, girdilerinin toplamının doğrusal olmayan bir fonksiyonu tarafından hesaplanır. Bağlantılara denir kenarlar. Nöronlar ve kenarlar tipik olarak bir ağırlık bu, öğrenme ilerledikçe ayarlanır. Ağırlık, bir bağlantıdaki sinyalin gücünü artırır veya azaltır. Nöronların bir eşiği olabilir, öyle ki bir sinyal yalnızca toplam sinyal bu eşiği geçerse gönderilir. Tipik olarak, nöronlar katmanlar halinde toplanır. Farklı katmanlar, girdileri üzerinde farklı dönüşümler gerçekleştirebilir. Sinyaller ilk katmandan (giriş katmanı) son katmana (çıktı katmanı), muhtemelen katmanları birden çok kez geçtikten sonra ilerler.

Eğitim

Sinir ağları, her biri bilinen bir "girdi" ve "sonuç" içeren ve ağın kendi veri yapısı içinde depolanan ikisi arasında olasılık ağırlıklı ilişkiler oluşturan örnekleri işleyerek öğrenir (veya eğitilir). Belirli bir örnekten bir sinir ağının eğitimi, genellikle ağın işlenmiş çıktısı (genellikle bir tahmin) ile bir hedef çıktı arasındaki farkın belirlenmesiyle gerçekleştirilir. Bu hata. Ağ daha sonra ağırlıklı ilişkilerini bir öğrenme kuralına göre ve bu hata değerini kullanarak ayarlar. Birbirini izleyen ayarlamalar, sinir ağının, hedef çıktıya giderek daha fazla benzeyen çıktı üretmesine neden olacaktır. Yeterli sayıda bu ayarlamadan sonra eğitim belirli kriterlere göre sonlandırılabilir. Bu olarak bilinir denetimli öğrenme.

Bu tür sistemler, genellikle göreve özgü kurallarla programlanmadan, örnekleri dikkate alarak görevleri gerçekleştirmeyi "öğrenirler". Örneğin, görüntü tanıma manuel olarak alınmış örnek resimleri analiz ederek kedileri içeren resimleri belirlemeyi öğrenebilirler. etiketli "kedi" veya "kedi yok" olarak ve sonuçları diğer resimlerdeki kedileri tanımlamak için kullanmak. Bunu, örneğin kürkleri, kuyrukları, bıyıkları ve kedi benzeri yüzleri olduğu gibi önceden kedilere dair hiçbir bilgisi olmadan yaparlar. Bunun yerine, işledikleri örneklerden otomatik olarak tanımlayıcı özellikler üretirler.

Tarih

Warren McCulloch ve Walter Pitts[2] (1943), sinir ağları için bir hesaplama modeli oluşturarak konuyu açtı.[3] 1940'ların sonlarında, D. O. Hebb[4] mekanizmasına dayalı bir öğrenme hipotezi oluşturdu sinirsel esneklik olarak biliniyordu Hebbian öğrenimi. Farley ve Wesley A. Clark[5] (1954) bir Hebbian ağını simüle etmek için önce hesaplama makinelerini kullandı, ardından "hesap makineleri" olarak adlandırıldı. Rosenblatt[6] (1958) yarattı Algılayıcı.[7] Birçok katmana sahip ilk işlevsel ağlar tarafından yayınlandı Ivakhnenko ve Lapa, 1965'te Grup Veri İşleme Yöntemi.[8][9][10] Sürekli geri yayılımın temelleri[8][11][12][13] bağlamında türetildi kontrol teorisi tarafından Kelley[14] 1960'da ve Bryson 1961'de[15] prensiplerini kullanmak dinamik program.

1970 yılında Seppo Linnainmaa için genel yöntemi yayınladı otomatik farklılaşma (AD) ayrık bağlı iç içe geçmiş ağların ayırt edilebilir fonksiyonlar.[16][17] 1973'te, Dreyfus uyum sağlamak için geri yayılımı kullandı parametreleri hata gradyanlarıyla orantılı olarak kontrolörlerin sayısı.[18] Werbos 's (1975) geri yayılım algoritması, çok katmanlı ağların pratik eğitimini sağladı. 1982'de, Linnainmaa'nın AD yöntemini, yaygın olarak kullanılan şekilde sinir ağlarına uyguladı.[11][19] Daha sonra araştırma, aşağıdaki şekilde durdu Minsky ve Papert (1969),[20] temel algılayıcıların özel devreyi veya devreyi işleyemediğini ve bilgisayarların yararlı sinir ağlarını işlemek için yeterli güce sahip olmadığını keşfetti.

Geliştirilmesi metal oksit yarı iletken (MOS) Çok Büyük Ölçekli Entegrasyon (VLSI), şeklinde tamamlayıcı MOS (CMOS) teknolojisi, MOS'un artmasını sağladı transistör sayımları içinde dijital elektronik Bu, 1980'lerde pratik yapay sinir ağlarının geliştirilmesi için daha fazla işlem gücü sağladı.[21]

1992'de maksimum havuz yardımcı olmak için deformasyona en az kayma değişmezliği ve toleransı ile yardımcı olmak için tanıtıldı 3B nesne tanıma.[22][23][24] Schmidhuber çok seviyeli bir ağ hiyerarşisini benimsemiştir (1992), her seferinde bir seviye tarafından önceden eğitilmiştir. denetimsiz öğrenme ve ince ayarı geri yayılım.[25]

Geoffrey Hinton et al. (2006), ardışık ikili veya gerçek değerli katmanları kullanarak üst düzey bir temsil öğrenmeyi önerdi. gizli değişkenler Birlikte sınırlı Boltzmann makinesi[26] her katmanı modellemek için. 2012 yılında Ng ve Dean kediler gibi üst düzey kavramları yalnızca etiketlenmemiş görüntüleri izleyerek tanımayı öğrenen bir ağ oluşturdu.[27] Denetimsiz ön eğitim ve artırılmış bilgi işlem gücü GPU'lar ve dağıtılmış hesaplama özellikle görüntü ve görsel tanıma problemlerinde daha büyük ağların kullanımına izin verdi.derin öğrenme ".[28]

Ciresan ve arkadaşları (2010)[29] kaybolan gradyan sorununa rağmen, GPU'ların geri yayılımı çok katmanlı ileri beslemeli sinir ağları için uygun hale getirdiğini gösterdi.[30] 2009 ve 2012 yılları arasında YSA'lar, başlangıçta çeşitli görevlerde insan düzeyindeki performansa yaklaşarak YSA yarışmalarında ödüller kazanmaya başladı. desen tanıma ve makine öğrenme.[31][32] Örneğin, iki yönlü ve çok boyutlu uzun kısa süreli hafıza (LSTM)[33][34][35][36] nın-nin Mezarlar et al. 2009 yılında öğrenilecek üç dil hakkında herhangi bir ön bilgi olmaksızın bağlantılı el yazısı tanıma alanında üç yarışma kazandı.[35][34]

Ciresan ve meslektaşları, rekabete dayalı / insanüstü performans elde etmek için ilk model tanıyıcıları oluşturdu[37] trafik işareti tanıma gibi kıyaslamalar üzerinde (IJCNN 2012).

Modeller

Bu bölüm olabilir kafa karıştırıcı veya belirsiz okuyuculara. (Nisan 2017) (Bu şablon mesajını nasıl ve ne zaman kaldıracağınızı öğrenin) |

YSA'lar, geleneksel algoritmaların çok az başarılı olduğu görevleri gerçekleştirmek için insan beyninin mimarisinden yararlanma girişimi olarak başladı. Kısa süre sonra, çoğunlukla biyolojik öncüllerine sadık kalma girişimlerinden vazgeçerek, deneysel sonuçları iyileştirmeye yeniden yöneldiler. Nöronlar, bazı nöronların çıktısının diğerlerinin girdisi haline gelmesine izin vermek için birbirine çeşitli şekillerde bağlanır. Ağ bir yönetilen, ağırlıklı grafik.[38]

Yapay bir sinir ağı, simüle edilmiş nöronların bir koleksiyonundan oluşur. Her nöron bir düğüm ile diğer düğümlere bağlanan bağlantılar biyolojik akson-sinaps-dendrit bağlantılarına karşılık gelir. Her bağlantının, bir düğümün diğeri üzerindeki etkisinin gücünü belirleyen bir ağırlığı vardır.[39]

YSA Bileşenleri

Nöronlar

YSA'lar şunlardan oluşur: yapay nöronlar kavramsal olarak biyolojik nöronlar. Her bir yapay nöronun girdileri vardır ve diğer birçok nörona gönderilebilen tek bir çıktı üretir. Girişler, görüntüler veya belgeler gibi bir harici veri örneğinin özellik değerleri olabilir veya diğer nöronların çıktıları olabilir. Finalin çıktıları çıktı nöronları Sinir ağının, bir görüntüdeki bir nesneyi tanıma gibi görevi yerine getirir.

Nöronun çıktısını bulmak için, önce tüm girdilerin ağırlıklı toplamını alıyoruz. ağırlıklar of bağlantıları girdilerden nörona. Ekliyoruz önyargı bu meblağa dönem. Bu ağırlıklı toplam bazen aktivasyon. Bu ağırlıklı toplam daha sonra bir (genellikle doğrusal olmayan) aktivasyon fonksiyonu çıktı üretmek için. İlk girişler, resimler ve belgeler gibi harici verilerdir. Nihai çıktılar, bir görüntüdeki bir nesneyi tanımak gibi görevi yerine getirir.[40]

Bağlantılar ve ağırlıklar

Ağ, bağlantılardan oluşur, her bağlantı bir nöronun çıkışını başka bir nörona girdi olarak sağlar. Her bağlantıya, göreceli önemini temsil eden bir ağırlık atanır.[38] Belirli bir nöronun birden çok giriş ve çıkış bağlantısı olabilir.[41]

Yayılma işlevi

yayılma işlevi önceki nöronların çıktılarından ve bunların bağlantılarından ağırlıklı bir toplam olarak bir nöronun girdisini hesaplar.[38] Bir önyargı yayılmanın sonucuna terim eklenebilir.[42]

Organizasyon

Nöronlar tipik olarak birden çok katman halinde düzenlenir, özellikle derin öğrenme. Bir katmandaki nöronlar, yalnızca hemen önceki ve hemen sonraki katmanların nöronlarına bağlanır. Dış verileri alan katman, giriş katmanı. Nihai sonucu üreten katman, çıktı katmanı. Aralarında sıfır veya daha fazla gizli katmanlar. Tek katmanlı ve katmanlı olmayan ağlar da kullanılır. İki katman arasında birden fazla bağlantı modeli mümkündür. Onlar yapabilir tamamen bağlı, bir katmandaki her nöronun bir sonraki katmandaki her nörona bağlanmasıyla. Onlar yapabilir havuz, bir katmandaki bir grup nöronun bir sonraki katmandaki tek bir nörona bağlandığı ve böylece o katmandaki nöron sayısını azalttığı.[43] Sadece bu tür bağlantılara sahip nöronlar bir Yönlendirilmiş döngüsüz grafiği ve olarak bilinir ileri beslemeli ağlar.[44] Alternatif olarak, aynı veya önceki katmanlardaki nöronlar arasında bağlantılara izin veren ağlar olarak bilinir. tekrarlayan ağlar.[45]

Hiperparametre

Bir hiperparametre sabittir parametre Değeri öğrenme süreci başlamadan önce belirlenir. Parametrelerin değerleri öğrenme yoluyla elde edilir. Hiperparametre örnekleri şunları içerir: öğrenme oranı, gizli katmanların sayısı ve toplu iş boyutu.[46] Bazı hiperparametrelerin değerleri, diğer hiperparametrelerin değerlerine bağlı olabilir. Örneğin, bazı katmanların boyutu, toplam katman sayısına bağlı olabilir.

Öğrenme

Bu bölüm şunları içerir: referans listesi, ilgili okuma veya Dış bağlantılar, ancak kaynakları belirsizliğini koruyor çünkü eksik satır içi alıntılar. (Ağustos 2019) (Bu şablon mesajını nasıl ve ne zaman kaldıracağınızı öğrenin) |

Öğrenme, örnek gözlemleri dikkate alarak bir görevi daha iyi yerine getirmek için ağın uyarlanmasıdır. Öğrenme, sonucun doğruluğunu iyileştirmek için ağın ağırlıklarını (ve isteğe bağlı eşikleri) ayarlamayı içerir. Bu, gözlemlenen hataları en aza indirerek yapılır. Ek gözlemleri incelerken öğrenmenin tamamlanması, hata oranını yararlı bir şekilde azaltmaz. Öğrendikten sonra bile, hata oranı tipik olarak 0'a ulaşmaz. Öğrendikten sonra hata oranı çok yüksekse, ağ tipik olarak yeniden tasarlanmalıdır. Pratik olarak bu, bir tanımlanarak yapılır. maliyet fonksiyonu öğrenme sırasında periyodik olarak değerlendirilir. Çıktısı düşmeye devam ettiği sürece öğrenme devam eder. Maliyet genellikle bir istatistik kimin değeri yalnızca yaklaşık olarak tahmin edilebilir. Çıktılar aslında sayılardır, bu nedenle hata düşük olduğunda, çıktı (neredeyse kesinlikle bir kedi) ile doğru yanıt (kedi) arasındaki fark küçüktür. Öğrenme, gözlemler arasındaki farkların toplamını azaltmaya çalışır.[38] Çoğu öğrenme modeli, aşağıdakilerin basit bir uygulaması olarak görülebilir: optimizasyon teori ve istatistiksel tahmin.

Öğrenme oranı

Öğrenme oranı, modelin her gözlemdeki hataları ayarlamak için attığı düzeltici adımların boyutunu tanımlar. Yüksek bir öğrenme oranı, eğitim süresini kısaltır, ancak daha düşük nihai doğrulukla, daha düşük bir öğrenme oranı daha uzun sürer, ancak daha fazla doğruluk potansiyeline sahiptir. Gibi optimizasyonlar Quickprop temelde hata minimizasyonunu hızlandırmayı hedeflerken, diğer iyileştirmeler esas olarak güvenilirliği artırmaya çalışır. Ağ içinde değişen bağlantı ağırlıkları gibi salınımları önlemek ve yakınsama oranını iyileştirmek için iyileştirmeler bir uyarlanabilir öğrenme oranı uygun şekilde artar veya azalır.[47] Momentum kavramı, gradyan ile önceki değişiklik arasındaki dengenin ağırlık ayarlamasının bir dereceye kadar önceki değişikliğe bağlı olacağı şekilde ağırlıklandırılmasına izin verir. 0'a yakın bir momentum gradyanı vurgularken 1'e yakın bir değer son değişikliği vurgular.

Maliyet fonksiyonu

Bir maliyet fonksiyonu tanımlamak mümkün olsa da özel, genellikle seçim, işlevin istenen özelliklerine göre belirlenir (örneğin dışbükeylik ) veya modelden kaynaklandığı için (örneğin olasılıklı bir modelde modelin arka olasılık ters bir maliyet olarak kullanılabilir).

Geri yayılım

Geri yayılım, öğrenme sırasında bulunan her hatayı telafi etmek için bağlantı ağırlıklarını ayarlama yöntemidir. Hata miktarı, bağlantılar arasında etkin bir şekilde bölünür. Teknik olarak, backprop hesaplar gradyan (türevi) maliyet fonksiyonu ağırlıklara göre belirli bir durumla ilişkili. Kilo güncellemeleri şu yolla yapılabilir: stokastik gradyan inişi veya diğer yöntemler, örneğin Ekstrem Öğrenme Makineleri,[48] "Desteksiz" ağlar,[49] geri izleme olmadan eğitim,[50] "ağırlıksız" ağlar,[51][52] ve bağlantısız sinir ağları.

Öğrenme paradigmaları

Bu bölüm şunları içerir: referans listesi, ilgili okuma veya Dış bağlantılar, ancak kaynakları belirsizliğini koruyor çünkü eksik satır içi alıntılar. (Ağustos 2019) (Bu şablon mesajını nasıl ve ne zaman kaldıracağınızı öğrenin) |

Üç ana öğrenme paradigması denetimli öğrenme, denetimsiz öğrenme ve pekiştirmeli öğrenme. Her biri belirli bir öğrenme görevine karşılık gelir

Denetimli öğrenme

Denetimli öğrenme bir dizi eşleştirilmiş giriş ve istenen çıkış kullanır. Öğrenme görevi, her girdi için istenen çıktıyı üretmektir. Bu durumda maliyet fonksiyonu, yanlış kesintileri ortadan kaldırmakla ilgilidir.[53] Yaygın olarak kullanılan bir maliyet, ortalama kare hatası, ağın çıktısı ile istenen çıktı arasındaki ortalama karesel hatayı en aza indirmeye çalışır. Denetimli öğrenim için uygun görevler desen tanıma (ayrıca sınıflandırma olarak da bilinir) ve gerileme (aynı zamanda fonksiyon yaklaşımı olarak da bilinir). Denetimli öğrenme, sıralı verilere de uygulanabilir (örneğin, el yazısı, konuşma ve mimik tanıma ). Bu, şimdiye kadar elde edilen çözümlerin kalitesi hakkında sürekli geri bildirim sağlayan bir işlev şeklinde bir "öğretmen" ile öğrenme olarak düşünülebilir.

Denetimsiz öğrenme

İçinde denetimsiz öğrenme, girdi verileri maliyet fonksiyonu ile birlikte verilir, verilerin bazı fonksiyonları ve ağın çıktısı. Maliyet işlevi göreve (model etki alanına) ve herhangi bir Önsel varsayımlar (modelin örtük özellikleri, parametreleri ve gözlemlenen değişkenler). Önemsiz bir örnek olarak, modeli düşünün nerede sabit ve maliyet . Bu maliyeti en aza indirmek, bir değer üretir bu verilerin ortalamasına eşittir. Maliyet fonksiyonu çok daha karmaşık olabilir. Şekli uygulamaya bağlıdır: örneğin sıkıştırma ile ilgili olabilir karşılıklı bilgi arasında ve istatistiksel modellemede ise, arka olasılık veriler verilen modelin (bu örneklerin her ikisinde de bu miktarların en aza indirilmek yerine maksimize edileceğine dikkat edin). Denetimsiz öğrenme paradigmasına giren görevler genel olarak tahmin sorunlar; uygulamalar şunları içerir kümeleme, tahmini istatistiksel dağılımlar, sıkıştırma ve süzme.

Takviye öğrenme

Video oyunları oynamak gibi uygulamalarda, bir oyuncu bir dizi eylemde bulunur ve her birinden sonra çevreden genel olarak tahmin edilemeyen bir yanıt alır. Amaç, oyunu kazanmak, yani en olumlu (en düşük maliyetli) yanıtları üretmektir. İçinde pekiştirmeli öğrenme amaç, uzun vadeli (beklenen kümülatif) maliyeti en aza indiren eylemleri gerçekleştirmek için ağı ağırlıklandırmaktır (bir politika tasarlamak). Zamanın her noktasında temsilci bir eylem gerçekleştirir ve ortam bazı (genellikle bilinmeyen) kurallara göre bir gözlem ve anlık bir maliyet oluşturur. Kurallar ve uzun vadeli maliyet genellikle yalnızca tahmin edilebilir. Herhangi bir noktada, aracı, maliyetlerini ortaya çıkarmak için yeni eylemler keşfetmeye mi yoksa daha hızlı ilerlemek için öğrenmeden önce yararlanmaya mı karar verir.

Biçimsel olarak çevre bir Markov karar süreci (MDP) durumlarla ve eylemler . Durum geçişleri bilinmediğinden, bunun yerine olasılık dağılımları kullanılır: anlık maliyet dağılımı gözlem dağılımı ve geçiş dağılımı bir politika ise gözlemler verilen eylemler üzerinden koşullu dağılım olarak tanımlanır. Birlikte ele alındığında, ikisi bir Markov zinciri (MC). Amaç, en düşük maliyetli MC'yi keşfetmektir.

YSA'lar, bu tür uygulamalarda öğrenme bileşeni olarak hizmet eder.[54][55] Dinamik program YSA'larla birleştiğinde (nörodinamik programlama sağlar)[56] dahil olanlar gibi sorunlara uygulanmıştır araç rotası,[57] video oyunları, doğal kaynak Yönetimi[58][59] ve ilaç[60] YSA'nın kontrol problemlerinin çözümüne sayısal olarak yaklaşmak için ayrıklaştırma ızgara yoğunluğunu düşürürken bile doğruluk kayıplarını azaltma kabiliyeti nedeniyle. Pekiştirmeli öğrenme paradigmasına giren görevler kontrol problemleridir, oyunlar ve diğer sıralı karar verme görevleri.

Kendi kendine öğrenme

Sinir ağlarında kendi kendine öğrenme, Crossbar Adaptive Array (CAA) adlı kendi kendine öğrenebilen bir sinir ağıyla birlikte 1982'de tanıtıldı.[61] Yalnızca bir girişi, durumu s ve yalnızca bir çıkışı, eylemi (veya davranışı) olan bir sistemdir a. Çevreden ne dış tavsiye girdisi ne de dış destek girdisi vardır. CAA, çapraz bir şekilde, karşılaşılan durumlar hakkındaki hem eylemler hakkındaki kararları hem de duyguları (hisleri) hesaplar. Sistem, biliş ve duygu arasındaki etkileşim tarafından yönlendirilir.[62] Bellek matrisi W = || w (a, s) || verildiğinde, her yinelemedeki çapraz çubuk kendi kendine öğrenme algoritması aşağıdaki hesaplamayı gerçekleştirir:

S durumunda a eylemini gerçekleştirin; Sonuç durumu s ’; Sonuç durumunda v (s ’) olma duygusunu hesaplayın; Çapraz çubuk belleğini güncelleyin w ’(a, s) = w (a, s) + v (s’).

Geri yayılmış değer (ikincil pekiştirme), sonuç durumuna yönelik duygudur. CAA iki ortamda bulunur; biri davranışsal ortamdır, diğeri ise davranışsal ortamda karşılaşılacak durumlarla ilgili ilk duyguları başlangıçta ve yalnızca bir kez aldığı genetik ortamdır. Genom vektörünü (tür vektörü) genetik ortamdan alan CAA, hem istenen hem de istenmeyen durumları içeren davranışsal ortamda bir hedef arama davranışını öğrenecektir.[63]

Diğer

İçinde Bayes maliyeti en aza indirmek için izin verilen modeller kümesi üzerinden bir dağıtım seçilir. Evrimsel yöntemler,[64] gen ifade programlama,[65] benzetimli tavlama,[66] beklenti maksimizasyonu, parametrik olmayan yöntemler ve parçacık sürüsü optimizasyonu[67] diğer öğrenme algoritmalarıdır. Yakınsak özyineleme, aşağıdakiler için bir öğrenme algoritmasıdır: serebellar model artikülasyon denetleyicisi (CMAC) sinir ağları.[68][69]

Modları

Bu bölüm şunları içerir: referans listesi, ilgili okuma veya Dış bağlantılar, ancak kaynakları belirsizliğini koruyor çünkü eksik satır içi alıntılar. (Ağustos 2019) (Bu şablon mesajını nasıl ve ne zaman kaldıracağınızı öğrenin) |

İki öğrenme modu mevcuttur: stokastik ve toplu. Stokastik öğrenmede, her girdi bir ağırlık ayarı oluşturur. Toplu öğrenmede ağırlıklar, bir grup girdiye göre ayarlanır ve toplu iş üzerinde hatalar biriktirilir. Stokastik öğrenme, bir veri noktasından hesaplanan yerel gradyanı kullanarak sürece "gürültü" getirir; bu, ağın yerel minimumda kalma olasılığını azaltır. Bununla birlikte, toplu öğrenme tipik olarak yerel bir minimuma daha hızlı, daha istikrarlı bir düşüş sağlar, çünkü her güncelleme, partinin ortalama hatası doğrultusunda gerçekleştirilir. Yaygın bir uzlaşma, tüm veri setinden stokastik olarak seçilen her partide numuneler içeren küçük partiler olan "mini partiler" kullanmaktır.

Türler

YSA'lar, en son teknolojiyi birden çok alanda ilerleten geniş bir teknikler ailesine dönüşmüştür. En basit tipler, birim sayısı, katman sayısı, birim ağırlıkları ve dahil olmak üzere bir veya daha fazla statik bileşene sahiptir. topoloji. Dinamik türler, bunlardan bir veya daha fazlasının öğrenme yoluyla gelişmesine izin verir. İkincisi çok daha karmaşıktır, ancak öğrenme sürelerini kısaltabilir ve daha iyi sonuçlar verebilir. Bazı türler öğrenmenin operatör tarafından "denetlenmesine" izin verir / gerektirirken diğerleri bağımsız olarak çalışır. Bazı türler yalnızca donanımda çalışırken diğerleri yalnızca yazılımdır ve genel amaçlı bilgisayarlarda çalışır.

Başlıca buluşlardan bazıları şunlardır: evrişimli sinir ağları görsel ve diğer iki boyutlu verileri işlemede özellikle başarılı olduğu kanıtlanmış;[70][71] uzun kısa süreli hafıza kaybolan gradyan sorunu[72] ve düşük ve yüksek frekans bileşenlerinin bir karışımına sahip sinyalleri işleyebilir ve geniş kelime dağarcığındaki konuşma tanımaya yardımcı olabilir,[73][74] metinden sese sentezi,[75][11][76] ve fotoğraf gerçekliğinde konuşan kafalar;[77] gibi rekabetçi ağlar üretici düşmanlık ağları içinde oyun kazanma gibi görevlerde birden fazla ağın (farklı yapıdaki) birbiriyle rekabet ettiği[78] veya bir girdinin gerçekliği konusunda rakibi kandırmak.[79]

Ağ tasarımı

Sinir mimarisi araması (NAS), YSA tasarımını otomatikleştirmek için makine öğrenimini kullanır. NAS'a yönelik çeşitli yaklaşımlar, elle tasarlanmış sistemlerle iyi karşılaştırılan ağlar tasarlamıştır. Temel arama algoritması, bir aday model önermek, bunu bir veri kümesine göre değerlendirmek ve sonuçları NAS ağına öğretmek için geri bildirim olarak kullanmaktır.[80] Mevcut sistemler şunları içerir: AutoML ve AutoKeras.[81]

Tasarım sorunları arasında, ağ katmanlarının sayısı, türü ve bağlantısının yanı sıra her birinin boyutuna ve bağlantı türüne (dolu, havuz oluşturma, ...) karar verilmesi yer alır.

Hiperparametreler her katmanda kaç nöron olduğu, öğrenme hızı, adım, adım, derinlik, alıcı alan ve dolgu (CNN'ler için) gibi konuları yöneten (öğrenilmemişler) tasarımın bir parçası olarak da tanımlanmalıdır.[82]

Kullanım

Yapay sinir ağlarını kullanmak, özelliklerinin anlaşılmasını gerektirir.

- Model seçimi: Bu, veri sunumuna ve uygulamaya bağlıdır. Aşırı karmaşık modeller öğrenmeyi yavaşlatır.

- Öğrenme algoritması: Öğrenme algoritmaları arasında çok sayıda değiş tokuş vardır. Hemen hemen her algoritma doğru olanla iyi çalışacaktır. hiperparametreler belirli bir veri seti üzerine eğitim için. Ancak, görünmeyen veriler üzerinde eğitim için bir algoritma seçmek ve ayarlamak önemli deneyimler gerektirir.

- Sağlamlık: Model, maliyet fonksiyonu ve öğrenme algoritması uygun şekilde seçilirse, ortaya çıkan YSA sağlam hale gelebilir.

YSA yetenekleri aşağıdaki geniş kategorilere girer:[kaynak belirtilmeli ]

- Fonksiyon yaklaşımı veya regresyon analizi, dahil olmak üzere zaman serisi tahmini, uygunluk yaklaşımı ve modelleme.

- Sınıflandırma, dahil olmak üzere Desen ve dizi tanıma, yenilik tespiti ve sıralı karar verme.[83]

- Veri işleme filtreleme, kümeleme dahil, kör kaynak ayrımı ve sıkıştırma.

- Robotik manipülatörleri yönetmek dahil ve protezler.

Başvurular

Doğrusal olmayan süreçleri yeniden üretme ve modelleme yetenekleri nedeniyle, Yapay sinir ağları birçok disiplinde uygulama bulmuştur. Uygulama alanları şunları içerir: sistem kimliği ve kontrol (araç kontrolü, yörünge tahmini,[84] Süreç kontrolü, doğal kaynak Yönetimi ), kuantum kimyası,[85] genel oyun oynama,[86] desen tanıma (radar sistemleri, yüz tanıma sinyal sınıflandırması,[87] 3D rekonstrüksiyon,[88] nesne tanıma ve daha fazlası), sıra tanıma (hareket, konuşma, el yazısı ve basılı metin tanıma), tıbbi teşhis, finans[89] (Örneğin. otomatik ticaret sistemleri ), veri madenciliği görselleştirme makine çevirisi, sosyal ağ filtreleme[90] ve e-posta spam'ı filtreleme. YSA'lar çeşitli kanser türlerini teşhis etmek için kullanılmıştır[91] [92] ve sadece hücre şekli bilgisini kullanarak yüksek düzeyde istilacı kanser hücre çizgilerini daha az invaziv çizgilerden ayırt etmek.[93][94]

Doğal afetlere maruz kalan altyapıların güvenilirlik analizini hızlandırmak için YSA'lar kullanılmıştır.[95][96] ve vakıf yerleşimlerini tahmin etmek.[97] YSA'lar ayrıca kara kutu modelleri oluşturmak için de kullanılmıştır. yerbilim: hidroloji,[98][99] okyanus modelleme ve kıyı mühendisliği,[100][101] ve jeomorfoloji.[102] YSA'lar, siber güvenlik meşru etkinlikler ile kötü niyetli olanlar arasında ayrım gözetmek amacıyla. Örneğin, Android kötü amaçlı yazılımlarını sınıflandırmak için makine öğrenimi kullanılmıştır.[103] tehdit aktörlerine ait etki alanlarını belirlemek ve güvenlik riski oluşturan URL'leri tespit etmek için.[104] Botnet'leri tespit etmek için sızma testi için tasarlanmış YSA sistemleri üzerinde araştırmalar devam etmektedir,[105] kredi kartı sahtekarlıkları[106] ve ağ izinsiz girişleri.

YSA'lar çözmek için bir araç olarak önerildi kısmi diferansiyel denklemler fizikte[107] ve birçok cismin özelliklerini simüle edin açık kuantum sistemleri.[108][109][110][111] Beyin araştırmasında YSA'lar, kısa vadeli davranışları inceledi. bireysel nöronlar,[112] Sinir devresinin dinamikleri, bireysel nöronlar arasındaki etkileşimlerden ve tam alt sistemleri temsil eden soyut sinir modüllerinden davranışların nasıl ortaya çıkabileceğinden kaynaklanır. Çalışmalar, sinir sistemlerinin uzun ve kısa vadeli esnekliğini ve bunların bireysel nörondan sistem seviyesine kadar öğrenme ve hafıza ile ilişkisini ele aldı.

Teorik özellikler

Hesaplama gücü

çok katmanlı algılayıcı bir evrensel işlev yaklaşımcı, tarafından kanıtlandığı üzere evrensel yaklaşım teoremi. Bununla birlikte, gerekli nöron sayısı, ağ topolojisi, ağırlıklar ve öğrenme parametreleri ile ilgili kanıt yapıcı değildir.

Belirli bir yinelenen mimari ile akılcı değerli ağırlıklar (tam hassasiyetin aksine gerçek Numara değerli ağırlıklar) bir evrensel Turing makinesi,[113] sınırlı sayıda nöron ve standart doğrusal bağlantılar kullanarak. Ayrıca, kullanımı irrasyonel ağırlık değerleri, süper Turing güç.[114]

Kapasite

Bir modelin "kapasite" özelliği, herhangi bir belirli işlevi modelleme yeteneğine karşılık gelir. Ağda depolanabilecek bilgi miktarı ve karmaşıklık kavramı ile ilgilidir. İki kapasite kavramı toplum tarafından bilinmektedir. Bilgi kapasitesi ve VC Boyutu. Bir algılayıcının bilgi kapasitesi yoğun bir şekilde Sir David MacKay'in kitabında tartışılmaktadır. [115] Thomas Cover'ın çalışmasını özetleyen.[116] Standart nöron ağının kapasitesi (evrişimli değil) dört kuralla elde edilebilir [117] bir nöronu bir elektriksel eleman. Bilgi kapasitesi, herhangi bir veri girdi olarak verilen ağ tarafından modellenebilen fonksiyonları yakalar. İkinci fikir, VC boyutu. VC Dimension şu ilkeleri kullanır: teori ölçmek ve mümkün olan en iyi koşullarda maksimum kapasiteyi bulur. Bu, giriş verileri belirli bir biçimde verilir. Belirtildiği gibi,[115] keyfi girişler için VC Boyutu, bir Perceptron'un bilgi kapasitesinin yarısıdır. Rastgele noktalar için VC Boyutuna bazen Bellek Kapasitesi adı verilir.[118]

Yakınsama

Modeller, tek bir çözüme tutarlı bir şekilde yaklaşmayabilir, çünkü ilk olarak, maliyet fonksiyonu ve modele bağlı olarak yerel minimumlar mevcut olabilir. İkinci olarak, kullanılan optimizasyon yöntemi herhangi bir yerel minimumdan çok uzak başladığında yakınsamayı garanti etmeyebilir. Üçüncüsü, yeterince büyük veri veya parametreler için bazı yöntemler uygulanamaz hale gelir.

Bazı YSA mimarisi türlerinin yakınsama davranışı diğerlerinden daha anlaşılır. Ağın genişliği sonsuza yaklaştığında, YSA eğitim boyunca birinci dereceden Taylor genişlemesi ile iyi tanımlanır ve bu nedenle YSA'nın yakınsama davranışını miras alır. afin modeller.[119][120] Diğer bir örnek, parametreler küçük olduğunda, YSA'ların genellikle düşük frekanslardan yüksek frekanslara hedef fonksiyonlara uyduğu gözlemlenmiştir.[121][122][123][124] Bu fenomen, iyi çalışılmış bazı yinelemeli sayısal şemaların davranışının tam tersidir. Jacobi yöntemi.

Genelleme ve istatistikler

Bu bölüm şunları içerir: referans listesi, ilgili okuma veya Dış bağlantılar, ancak kaynakları belirsizliğini koruyor çünkü eksik satır içi alıntılar. (Ağustos 2019) (Bu şablon mesajını nasıl ve ne zaman kaldıracağınızı öğrenin) |

Amacı, görünmeyen örneklere iyi genelleyen bir sistem oluşturmak olan uygulamalar, aşırı eğitim olasılığı ile karşı karşıyadır. Bu, ağ kapasitesi gerekli serbest parametreleri önemli ölçüde aştığında kıvrımlı veya aşırı belirlenmiş sistemlerde ortaya çıkar. Aşırı eğitimi ele alan iki yaklaşım vardır. İlki kullanmak çapraz doğrulama aşırı eğitim olup olmadığını kontrol etmek ve seçmek için benzer teknikler hiperparametreler genelleme hatasını en aza indirmek için.

İkincisi, bir tür kullanmaktır düzenleme. Bu kavram, olasılıkçı (Bayesçi) bir çerçevede ortaya çıkar; burada düzenlileştirme, daha basit modellere göre daha büyük bir önceki olasılık seçilerek yapılabilir; ama aynı zamanda, amacın iki nicelikten fazlasını en aza indirgemek olduğu istatistiksel öğrenme teorisinde: eğitim setindeki hataya ve aşırı uyum nedeniyle görünmeyen verilerdeki tahmin edilen hataya kabaca karşılık gelen 'ampirik risk' ve 'yapısal risk'.

Kullanan denetimli sinir ağları ortalama karesel hata (MSE) maliyet işlevi, eğitilmiş modelin güvenirliğini belirlemek için resmi istatistiksel yöntemler kullanabilir. Bir doğrulama setindeki MSE, varyans için bir tahmin olarak kullanılabilir. Bu değer daha sonra hesaplamak için kullanılabilir. güven aralığı ağ çıktısının normal dağılım. Bu şekilde yapılan bir güven analizi, çıktı olduğu sürece istatistiksel olarak geçerlidir. olasılık dağılımı aynı kalır ve ağ değiştirilmez.

Atayarak softmax aktivasyon fonksiyonu bir genelleme lojistik fonksiyon Kategorik hedef değişkenler için sinir ağının (veya bileşen tabanlı bir ağdaki bir softmax bileşeninin) çıktı katmanında, çıktılar arka olasılıklar olarak yorumlanabilir. Bu, sınıflandırmalarda kesinlik ölçüsü verdiği için sınıflandırmada kullanışlıdır.

Softmax aktivasyon işlevi:

Eleştiri

Eğitim

Özellikle robotikte sinir ağlarına yönelik yaygın bir eleştiri, gerçek dünya operasyonları için çok fazla eğitim gerektirmeleridir.[kaynak belirtilmeli ] Potansiyel çözümler arasında, bir örneği takip ederek ağ bağlantılarını değiştirirken çok büyük adımlar atmayan sayısal bir optimizasyon algoritması kullanarak, örnekleri mini gruplar halinde gruplayarak ve / veya için yinelemeli bir en küçük kareler algoritması sunarak rastgele karıştırılan eğitim örneklerini içerir. CMAC.[68]

Teori

Temel bir itiraz, YSA'ların nöronal işlevi yeterince yansıtmamasıdır. Biyolojik sinir ağlarında böyle bir mekanizma bulunmamakla birlikte, geri yayılım kritik bir adımdır.[125] Bilginin gerçek nöronlar tarafından nasıl kodlandığı bilinmemektedir. Sensör nöronları ateş aksiyon potansiyalleri sensör aktivasyonu ile daha sık ve Kas hücreleri ilişkili oldukları zaman daha kuvvetli çekin motor nöronlar aksiyon potansiyellerini daha sık alırlar.[126] Bir sensör nörondan bir motor nörona bilgi aktarma durumu dışında, bilginin biyolojik sinir ağları tarafından nasıl ele alındığına dair neredeyse hiçbir prensip bilinmemektedir.

YSA'ların temel iddialarından biri, bilgi işlemeye yönelik yeni ve güçlü genel ilkeleri içermeleridir. Ne yazık ki, bu ilkeler yanlış tanımlanmıştır. Genellikle oldukları iddia edilir ortaya çıkan ağın kendisinden. Bu, basit istatistiksel ilişkinin (yapay sinir ağlarının temel işlevi) öğrenme veya tanıma olarak tanımlanmasına izin verir. Alexander Dewdney Sonuç olarak, yapay sinir ağlarının "sıfıra bir şey" niteliğine sahip olduğunu, tuhaf bir tembellik havası ve bu bilgi işlem sistemlerinin ne kadar iyi olduğuna dair belirgin bir merak eksikliği olduğunu yorumladı. İnsan eli (veya zihni) yok. müdahale eder; çözümler sihir yoluyla bulunur ve görünüşe göre hiç kimse bir şey öğrenmemiştir ".[127] Dewdney'e verilen yanıtlardan biri, sinir ağlarının otonom uçan uçaklardan birçok karmaşık ve çeşitli görevi üstlenmesidir.[128] kredi kartı sahtekarlığını tespit etmek için oyuna hakim olmak için Git.

Teknoloji yazarı Roger Bridgman şu yorumu yaptı:

Örneğin sinir ağları, yalnızca yüksek cennete yönlendirildikleri için değil (ne olmadı?) Aynı zamanda nasıl çalıştığını anlamadan başarılı bir ağ yaratabileceğiniz için de var: davranış, büyük olasılıkla "opak, okunamaz bir tablo ... bilimsel bir kaynak olarak değersiz" olacaktır.

Bilimin teknoloji olmadığına dair kesin beyanına rağmen, Dewdney burada sinir ağlarını, onları tasarlayanların çoğu sadece iyi mühendisler olmaya çalışırken kötü bilim olarak talan ediyor gibi görünüyor. Yararlı bir makinenin okuyabileceği okunamayan bir tablo, yine de sahip olmaya değerdir.[129]

Biyolojik beyinler, beyin anatomisi tarafından bildirildiği üzere hem sığ hem de derin devreleri kullanır.[130] çok çeşitli değişmezlik sergiliyor. Weng[131] Beynin büyük ölçüde sinyal istatistiklerine göre kendi kendine bağlantı kurduğunu ve bu nedenle bir seri kademenin tüm önemli istatistiksel bağımlılıkları yakalayamayacağını savundu.

Donanım

Büyük ve etkili sinir ağları, önemli bilgi işlem kaynakları gerektirir.[132] Beyin, sinyalleri bir aracılığıyla işleme görevine göre uyarlanmış donanıma sahipken grafik basitleştirilmiş bir nöronu bile simüle eden nöronların von Neumann mimarisi çok miktarda tüketebilir hafıza ve depolama. Dahası, tasarımcının sinyalleri bu bağlantıların birçoğu ve bunlarla ilişkili nöronlar aracılığıyla iletmesi gerekir - İşlemci güç ve zaman.

Schmidhuber yirmi birinci yüzyılda sinir ağlarının yeniden dirilişinin büyük ölçüde donanımdaki ilerlemelere atfedilebileceğini kaydetti: 1991'den 2015'e kadar, bilgi işlem gücü, özellikle de GPGPU'lar (açık GPU'lar ), has increased around a million-fold, making the standard backpropagation algorithm feasible for training networks that are several layers deeper than before.[8] The use of accelerators such as FPGA'lar and GPUs can reduce training times from months to days.[133][132]

Nöromorfik mühendislik addresses the hardware difficulty directly, by constructing non-von-Neumann chips to directly implement neural networks in circuitry. Another type of chip optimized for neural network processing is called a Tensor Processing Unit, or TPU.[134]

Practical counterexamples

Analyzing what has been learned by an ANN, is much easier than to analyze what has been learned by a biological neural network. Furthermore, researchers involved in exploring learning algorithms for neural networks are gradually uncovering general principles that allow a learning machine to be successful. For example, local vs. non-local learning and shallow vs. deep architecture.[135]

Hybrid approaches

Avukatları melez models (combining neural networks and symbolic approaches), claim that such a mixture can better capture the mechanisms of the human mind.[136][137]

Fotoğraf Galerisi

A single-layer feedforward artificial neural network. Arrows originating from are omitted for clarity. There are p inputs to this network and q outputs. In this system, the value of the qth output, would be calculated as

A two-layer feedforward artificial neural network.

An artificial neural network.

An ANN dependency graph.

A single-layer feedforward artificial neural network with 4 inputs, 6 hidden and 2 outputs. Given position state and direction outputs wheel based control values.

A two-layer feedforward artificial neural network with 8 inputs, 2x8 hidden and 2 outputs. Given position state, direction and other environment values outputs thruster based control values.

Parallel pipeline structure of CMAC neural network. This learning algorithm can converge in one step.

Ayrıca bakınız

Bu "see also" Bölüm aşırı sayıda öneri içerebilir. Lütfen yalnızca en alakalı bağlantıların verildiğinden, kırmızı bağlantılarve herhangi bir bağlantının bu makalede bulunmadığını. (Mart 2018) (Bu şablon mesajını nasıl ve ne zaman kaldıracağınızı öğrenin) |

- Sinir ağlarının geniş genişlik sınırları

- Hiyerarşik zamansal bellek

- 20Q

- ADALINE

- Uyarlamalı rezonans teorisi

- Yapay yaşam

- Associative memory

- Otomatik kodlayıcı

- BEAM robotics

- Biyolojik sibernetik

- Biyolojik açıdan ilham alan bilgi işlem

- Blue Brain Project

- Catastrophic interference

- Cerebellar Model Articulation Controller (CMAC)

- Cognitive architecture

- Bilişsel bilim

- Evrişimli sinir ağı (CNN)

- Bağlantıcı uzman sistemi

- Konektomikler

- Kültürlü nöronal ağlar

- Derin öğrenme

- Encog

- Bulanık mantık

- Gene expression programming

- Genetik Algoritma

- Genetik programlama

- Grup veri işleme yöntemi

- Alışma

- Yerinde Uyarlanabilir Tablolama

- Machine learning concepts

- Models of neural computation

- Nöroevrim

- Sinirsel kodlama

- Sinir gazı

- Sinir makinesi çevirisi

- Neural network software

- Sinirbilim

- Nonlinear system identification

- Optical neural network

- Parallel Constraint Satisfaction Processes

- Paralel dağıtılmış işleme

- Radyal temel fonksiyon ağı

- Tekrarlayan sinir ağları

- Kendi kendini organize eden harita

- Spiking neural network

- Sistolik dizi

- Tensör ürün ağı

- Zaman gecikmeli sinir ağı (TDNN)

Referanslar

- ^ Chen, Yung-Yao; Lin, Yu-Hsiu; Kung, Chia-Ching; Chung, Ming-Han; Yen, I.-Hsuan (January 2019). "Design and Implementation of Cloud Analytics-Assisted Smart Power Meters Considering Advanced Artificial Intelligence as Edge Analytics in Demand-Side Management for Smart Homes". Sensörler. 19 (9): 2047. doi:10.3390/s19092047. PMC 6539684. PMID 31052502.

- ^ McCulloch, Warren; Walter Pitts (1943). "Sinirsel Aktivitede İçkin Olan Mantıksal Bir Fikir Hesabı". Bulletin of Mathematical Biophysics. 5 (4): 115–133. doi:10.1007 / BF02478259.

- ^ Kleene, S.C. (1956). "Representation of Events in Nerve Nets and Finite Automata". Annals of Mathematics Studies (34). Princeton University Press. pp. 3–41. Alındı 17 Haziran 2017.

- ^ Hebb Donald (1949). Davranış Organizasyonu. New York: Wiley. ISBN 978-1-135-63190-1.

- ^ Farley, B.G.; W.A. Clark (1954). "Kendi Kendini Düzenleyen Sistemlerin Dijital Bilgisayarla Simülasyonu". Bilgi Teorisi Üzerine IRE İşlemleri. 4 (4): 76–84. doi:10.1109 / TIT.1954.1057468.

- ^ Rosenblatt, F. (1958). "The Perceptron: A Probabilistic Model For Information Storage And Organization In The Brain". Psikolojik İnceleme. 65 (6): 386–408. CiteSeerX 10.1.1.588.3775. doi:10.1037 / h0042519. PMID 13602029.

- ^ Werbos, P.J. (1975). Regresyonun Ötesinde: Davranış Bilimlerinde Tahmin ve Analiz İçin Yeni Araçlar.

- ^ a b c Schmidhuber, J. (2015). "Sinir Ağlarında Derin Öğrenme: Genel Bakış". Nöral ağlar. 61: 85–117. arXiv:1404.7828. doi:10.1016 / j.neunet.2014.09.003. PMID 25462637. S2CID 11715509.

- ^ Ivakhnenko, A. G. (1973). Cybernetic Predicting Devices. CCM Information Corporation.

- ^ Ivakhnenko, A. G.; Grigorʹevich Lapa, Valentin (1967). Cybernetics and forecasting techniques. American Elsevier Pub. Şti.

- ^ a b c Schmidhuber, Jürgen (2015). "Derin Öğrenme". Scholarpedia. 10 (11): 85–117. Bibcode:2015SchpJ..1032832S. doi:10.4249 / bilginler.32832.

- ^ Dreyfus, Stuart E. (1 September 1990). "Artificial neural networks, back propagation, and the Kelley-Bryson gradient procedure". Rehberlik, Kontrol ve Dinamikler Dergisi. 13 (5): 926–928. Bibcode:1990JGCD...13..926D. doi:10.2514/3.25422. ISSN 0731-5090.

- ^ Mizutani, E .; Dreyfus, S.E.; Nishio, K. (2000). "On derivation of MLP backpropagation from the Kelley-Bryson optimal-control gradient formula and its application". Proceedings of the IEEE-INNS-ENNS International Joint Conference on Neural Networks. IJCNN 2000. Neural Computing: New Challenges and Perspectives for the New Millennium. IEEE: 167–172 vol.2. doi:10.1109/ijcnn.2000.857892. ISBN 0769506194. S2CID 351146.

- ^ Kelley, Henry J. (1960). "Gradient theory of optimal flight paths". ARS Journal. 30 (10): 947–954. doi:10.2514/8.5282.

- ^ "A gradient method for optimizing multi-stage allocation processes". Proceedings of the Harvard Univ. Symposium on digital computers and their applications. Nisan 1961.

- ^ Linnainmaa, Seppo (1970). Bir algoritmanın kümülatif yuvarlama hatasının yerel yuvarlama hatalarının Taylor açılımı olarak gösterimi (Masters) (in Finnish). University of Helsinki. sayfa 6–7.

- ^ Linnainmaa, Seppo (1976). "Taylor expansion of the accumulated rounding error". BIT Sayısal Matematik. 16 (2): 146–160. doi:10.1007/bf01931367. S2CID 122357351.

- ^ Dreyfus, Stuart (1973). "The computational solution of optimal control problems with time lag". IEEE Transactions on Automatic Control. 18 (4): 383–385. doi:10.1109/tac.1973.1100330.

- ^ Werbos, Paul (1982). "Applications of advances in nonlinear sensitivity analysis" (PDF). System modeling and optimization. Springer. pp. 762–770.

- ^ Minsky, Marvin; Papert, Seymour (1969). Perceptrons: An Introduction to Computational Geometry. MIT Basın. ISBN 978-0-262-63022-1.

- ^ Mead, Carver A.; Ismail, Mohammed (8 May 1989). Sinir Sistemlerinin Analog VLSI Uygulaması (PDF). Mühendislik ve Bilgisayar Bilimlerinde Kluwer Uluslararası Serisi. 80. Norwell, MA: Kluwer Academic Publishers. doi:10.1007/978-1-4613-1639-8. ISBN 978-1-4613-1639-8.

- ^ J. Weng, N. Ahuja and T. S. Huang, "Cresceptron: a self-organizing neural network which grows adaptively," Proc. International Joint Conference on Neural Networks, Baltimore, Maryland, vol I, pp. 576–581, June, 1992.

- ^ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation of 3-D objects from 2-D images," Proc. 4th International Conf. Computer Vision, Berlin, Germany, pp. 121–128, May, 1993.

- ^ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation using the Cresceptron," International Journal of Computer Vision, cilt. 25, hayır. 2, pp. 105–139, Nov. 1997.

- ^ J. Schmidhuber., "Learning complex, extended sequences using the principle of history compression," Sinirsel Hesaplama, 4, pp. 234–242, 1992.

- ^ Smolensky, P. (1986). "Information processing in dynamical systems: Foundations of harmony theory.". In D. E. Rumelhart; J. L. McClelland; PDP Research Group (eds.). Paralel Dağıtılmış İşleme: Bilişin Mikro Yapısındaki Keşifler. 1. pp.194–281. ISBN 9780262680530.

- ^ Ng, Andrew; Dean Jeff (2012). "Büyük Ölçekli Denetimsiz Öğrenmeyi Kullanarak Üst Düzey Özellikler Oluşturma". arXiv:1112.6209 [cs.LG ].

- ^ Ian Goodfellow and Yoshua Bengio and Aaron Courville (2016). Deep Learning. MIT Basın.

- ^ Cireşan, Dan Claudiu; Meier, Ueli; Gambardella, Luca Maria; Schmidhuber, Jürgen (21 September 2010). "Deep, Big, Simple Neural Nets for Handwritten Digit Recognition". Sinirsel Hesaplama. 22 (12): 3207–3220. arXiv:1003.0358. doi:10.1162/neco_a_00052. ISSN 0899-7667. PMID 20858131. S2CID 1918673.

- ^ Dominik Scherer, Andreas C. Müller, and Sven Behnke: "Evaluation of Pooling Operations in Convolutional Architectures for Object Recognition," In 20th International Conference Artificial Neural Networks (ICANN), pp. 92–101, 2010. doi:10.1007/978-3-642-15825-4_10.

- ^ 2012 Kurzweil AI Interview Arşivlendi 31 August 2018 at the Wayback Makinesi ile Jürgen Schmidhuber on the eight competitions won by his Deep Learning team 2009–2012

- ^ "How bio-inspired deep learning keeps winning competitions | KurzweilAI". www.kurzweilai.net. Arşivlenen orijinal on 31 August 2018. Alındı 16 Haziran 2017.

- ^ Graves, Alex; and Schmidhuber, Jürgen; Offline Handwriting Recognition with Multidimensional Recurrent Neural Networks, in Bengio, Yoshua; Schuurmans, Dale; Lafferty, John; Williams, Chris K. I .; and Culotta, Aron (eds.), Advances in Neural Information Processing Systems 22 (NIPS'22), 7–10 December 2009, Vancouver, BC, Neural Information Processing Systems (NIPS) Foundation, 2009, pp. 545–552.

- ^ a b Graves, A .; Liwicki, M .; Fernandez, S .; Bertolami, R .; Bunke, H .; Schmidhuber, J. (2009). "Gelişmiş Kısıtlamasız El Yazısı Tanıma için Yeni Bir Bağlantısal Sistem" (PDF). Örüntü Analizi ve Makine Zekası Üzerine IEEE İşlemleri. 31 (5): 855–868. CiteSeerX 10.1.1.139.4502. doi:10.1109 / tpami.2008.137. PMID 19299860. S2CID 14635907.

- ^ a b Graves, Alex; Schmidhuber, Jürgen (2009). Bengio, Yoshua; Schuurmans, Dale; Lafferty, John; Williams, Chris editörü-K. BEN.; Culotta, Aron (editörler). "Çok Boyutlu Tekrarlayan Sinir Ağları ile Çevrimdışı El Yazısı Tanıma". Neural Information Processing Systems (NIPS) Foundation. Curran Associates, Inc: 545–552.

- ^ Graves, A .; Liwicki, M .; Fernández, S .; Bertolami, R .; Bunke, H .; Schmidhuber, J. (May 2009). "A Novel Connectionist System for Unconstrained Handwriting Recognition". Örüntü Analizi ve Makine Zekası Üzerine IEEE İşlemleri. 31 (5): 855–868. CiteSeerX 10.1.1.139.4502. doi:10.1109 / tpami.2008.137. ISSN 0162-8828. PMID 19299860. S2CID 14635907.

- ^ Ciresan, Dan; Meier, U.; Schmidhuber, J. (June 2012). Multi-column deep neural networks for image classification. 2012 IEEE Conference on Computer Vision and Pattern Recognition. pp. 3642–3649. arXiv:1202.2745. Bibcode:2012arXiv1202.2745C. CiteSeerX 10.1.1.300.3283. doi:10.1109/cvpr.2012.6248110. ISBN 978-1-4673-1228-8. S2CID 2161592.

- ^ a b c d Zell, Andreas (2003). "chapter 5.2". Simulation neuronaler Netze [Sinir Ağlarının Simülasyonu] (in German) (1st ed.). Addison-Wesley. ISBN 978-3-89319-554-1. OCLC 249017987.

- ^ Yapay zeka (3. baskı). Addison-Wesley Pub. Co. 1992. ISBN 0-201-53377-4.

- ^ "The Machine Learning Dictionary". www.cse.unsw.edu.au. Arşivlenen orijinal on 26 August 2018. Alındı 4 Kasım 2009.

- ^ Abbod, Maysam F (2007). "Application of Artificial Intelligence to the Management of Urological Cancer". Üroloji Dergisi. 178 (4): 1150–1156. doi:10.1016/j.juro.2007.05.122. PMID 17698099.

- ^ DAWSON, CHRISTIAN W (1998). "An artificial neural network approach to rainfall-runoff modelling". Hidrolojik Bilimler Dergisi. 43 (1): 47–66. doi:10.1080/02626669809492102.

- ^ Ciresan, Dan; Ueli Meier; Jonathan Masci; Luca M. Gambardella; Jurgen Schmidhuber (2011). "Flexible, High Performance Convolutional Neural Networks for Image Classification" (PDF). Proceedings of the Twenty-Second International Joint Conference on Artificial Intelligence-Volume Volume Two. 2: 1237–1242. Alındı 17 Kasım 2013.

- ^ Zell Andreas (1994). Simülasyon Neuronaler Netze [Sinir Ağlarının Simülasyonu] (in German) (1st ed.). Addison-Wesley. s. 73. ISBN 3-89319-554-8.

- ^ Miljanovic, Milos (February–March 2012). "Zaman Serisi Tahmininde Tekrarlayan ve Sonlu Dürtü Tepkisi Sinir Ağlarının Karşılaştırmalı Analizi" (PDF). Hint Bilgisayar ve Mühendislik Dergisi. 3 (1).

- ^ Lau, Suki (10 July 2017). "A Walkthrough of Convolutional Neural Network — Hyperparameter Tuning". Orta. Alındı 23 Ağustos 2019.

- ^ Li, Y .; Fu, Y .; Li, H.; Zhang, S. W. (1 June 2009). The Improved Training Algorithm of Back Propagation Neural Network with Self-adaptive Learning Rate. 2009 International Conference on Computational Intelligence and Natural Computing. 1. pp. 73–76. doi:10.1109/CINC.2009.111. ISBN 978-0-7695-3645-3. S2CID 10557754.

- ^ Huang, Guang-Bin; Zhu, Qin-Yu; Siew, Chee-Kheong (2006). "Extreme learning machine: theory and applications". Nöro hesaplama. 70 (1): 489–501. CiteSeerX 10.1.1.217.3692. doi:10.1016/j.neucom.2005.12.126.

- ^ Dul, Bernard; et al. (2013). "The no-prop algorithm: A new learning algorithm for multilayer neural networks". Nöral ağlar. 37: 182–188. doi:10.1016/j.neunet.2012.09.020. PMID 23140797.

- ^ Ollivier, Yann; Charpiat, Guillaume (2015). "Training recurrent networks without backtracking". arXiv:1507.07680 [cs.NE ].

- ^ ESANN. 2009

- ^ Hinton, G. E. (2010). "Kısıtlanmış Boltzmann Makinelerinin Eğitimi için Pratik Bir Kılavuz". Tech. Rep. UTML TR 2010-003.

- ^ Ojha, Varun Kumar; Abraham, Ajith; Snášel, Václav (1 April 2017). "Metaheuristic design of feedforward neural networks: A review of two decades of research". Yapay Zekanın Mühendislik Uygulamaları. 60: 97–116. arXiv:1705.05584. Bibcode:2017arXiv170505584O. doi:10.1016/j.engappai.2017.01.013. S2CID 27910748.

- ^ Dominic, S.; Das, R.; Whitley, D.; Anderson, C. (July 1991). "Genetic reinforcement learning for neural networks". IJCNN-91-Seattle International Joint Conference on Neural Networks. IJCNN-91-Seattle International Joint Conference on Neural Networks. Seattle, Washington, USA: IEEE. doi:10.1109/IJCNN.1991.155315. ISBN 0-7803-0164-1.

- ^ Hoskins, J.C.; Himmelblau, D.M. (1992). "Process control via artificial neural networks and reinforcement learning". Computers & Chemical Engineering. 16 (4): 241–251. doi:10.1016/0098-1354(92)80045-B.

- ^ Bertsekas, D.P.; Tsitsiklis, J.N. (1996). Neuro-dynamic programming. Athena Scientific. s. 512. ISBN 978-1-886529-10-6.

- ^ Secomandi, Nicola (2000). "Comparing neuro-dynamic programming algorithms for the vehicle routing problem with stochastic demands". Bilgisayarlar ve Yöneylem Araştırması. 27 (11–12): 1201–1225. CiteSeerX 10.1.1.392.4034. doi:10.1016/S0305-0548(99)00146-X.

- ^ de Rigo, D.; Rizzoli, A. E.; Soncini-Sessa, R.; Weber, E.; Zenesi, P. (2001). "Neuro-dynamic programming for the efficient management of reservoir networks". Proceedings of MODSIM 2001, International Congress on Modelling and Simulation. MODSIM 2001, International Congress on Modelling and Simulation. Canberra, Australia: Modelling and Simulation Society of Australia and New Zealand. doi:10.5281/zenodo.7481. ISBN 0-867405252.

- ^ Damas, M.; Salmeron, M.; Diaz, A.; Ortega, J .; Prieto, A .; Olivares, G. (2000). "Genetic algorithms and neuro-dynamic programming: application to water supply networks". Proceedings of 2000 Congress on Evolutionary Computation. 2000 Congress on Evolutionary Computation. La Jolla, California, USA: IEEE. doi:10.1109/CEC.2000.870269. ISBN 0-7803-6375-2.

- ^ Deng, Geng; Ferris, M.C. (2008). Neuro-dynamic programming for fractionated radiotherapy planning. Springer Optimization and Its Applications. 12. pp. 47–70. CiteSeerX 10.1.1.137.8288. doi:10.1007/978-0-387-73299-2_3. ISBN 978-0-387-73298-5.

- ^ Bozinovski, S. (1982). "A self learning system using secondary reinforcement". In R. Trappl (ed.) Cybernetics and Systems Research: Proceedings of the Sixth European Meeting on Cybernetics and Systems Research. North Holland. s. 397–402. ISBN 978-0-444-86488-8.

- ^ Bozinovski, S. (2014) "Modeling mechanisms of cognition-emotion interaction in artificial neural networks, since 1981." Procedia Computer Science p. 255-263

- ^ Bozinovski, Stevo; Bozinovska, Liljana (2001). "Self-learning agents: A connectionist theory of emotion based on crossbar value judgment". Sibernetik ve Sistemler. 32 (6): 637–667. doi:10.1080/01969720118145. S2CID 8944741.

- ^ de Rigo, D.; Castelletti, A.; Rizzoli, A. E.; Soncini-Sessa, R.; Weber, E. (January 2005). "A selective improvement technique for fastening Neuro-Dynamic Programming in Water Resources Network Management". In Pavel Zítek (ed.). Proceedings of the 16th IFAC World Congress – IFAC-PapersOnLine. 16th IFAC World Congress. 16. Prague, Czech Republic: IFAC. doi:10.3182/20050703-6-CZ-1902.02172. hdl:11311/255236. ISBN 978-3-902661-75-3. Alındı 30 Aralık 2011.

- ^ Ferreira, C. (2006). "Designing Neural Networks Using Gene Expression Programming" (PDF). In A. Abraham, B. de Baets, M. Köppen, and B. Nickolay, eds., Applied Soft Computing Technologies: The Challenge of Complexity, pages 517–536, Springer-Verlag.

- ^ Da, Y.; Xiurun, G. (July 2005). T. Villmann (ed.). An improved PSO-based ANN with simulated annealing technique. New Aspects in Neurocomputing: 11th European Symposium on Artificial Neural Networks. Elsevier. doi:10.1016/j.neucom.2004.07.002.

- ^ Wu, J .; Chen, E. (May 2009). Wang, H .; Shen, Y.; Huang, T .; Zeng, Z. (eds.). A Novel Nonparametric Regression Ensemble for Rainfall Forecasting Using Particle Swarm Optimization Technique Coupled with Artificial Neural Network. 6th International Symposium on Neural Networks, ISNN 2009. Springer. doi:10.1007/978-3-642-01513-7-6. ISBN 978-3-642-01215-0.

- ^ a b Ting Qin, et al. "A learning algorithm of CMAC based on RLS." Neural Processing Letters 19.1 (2004): 49–61.

- ^ Ting Qin, et al. "Continuous CMAC-QRLS and its systolic array." Neural Processing Letters 22.1 (2005): 1–16.

- ^ LeCun et al., "Backpropagation Applied to Handwritten Zip Code Recognition," Sinirsel Hesaplama, 1, pp. 541–551, 1989.

- ^ Yann LeCun (2016). Slides on Deep Learning İnternet üzerinden

- ^ Hochreiter, Sepp; Schmidhuber, Jürgen (1 November 1997). "Uzun Kısa Süreli Bellek". Sinirsel Hesaplama. 9 (8): 1735–1780. doi:10.1162/neco.1997.9.8.1735. ISSN 0899-7667. PMID 9377276. S2CID 1915014.

- ^ Sak, Hasim; Kıdemli, Andrew; Beaufays, Francoise (2014). "Büyük ölçekli akustik modelleme için Uzun Kısa Süreli Bellek tekrarlayan sinir ağı mimarileri" (PDF). Arşivlenen orijinal (PDF) 24 Nisan 2018.

- ^ Li, Xiangang; Wu, Xihong (15 October 2014). "Büyük Kelime Konuşma Tanıma için Uzun Kısa Süreli Bellek tabanlı Derin Tekrarlayan Sinir Ağları Oluşturma". arXiv:1410.4281 [cs.CL ].

- ^ Fan, Y.; Qian, Y.; Xie, F.; Soong, F. K. (2014). "TTS synthesis with bidirectional LSTM based Recurrent Neural Networks". Proceedings of the Annual Conference of the International Speech Communication Association, Interspeech: 1964–1968. Alındı 13 Haziran 2017.

- ^ Zen, Heiga; Sak, Hasim (2015). "Düşük Gecikmeli Konuşma Sentezi için Tekrarlayan Çıkış Katmanlı Tek Yönlü Uzun Kısa Süreli Hafızalı Tekrarlayan Sinir Ağı" (PDF). Google.com. ICASSP. sayfa 4470–4474.

- ^ Fan, Bo; Wang, Lijuan; Soong, Frank K .; Xie, Lei (2015). "Photo-Real Talking Head with Deep Bidirectional LSTM" (PDF). Proceedings of ICASSP.

- ^ Silver, David; Hubert, Thomas; Schrittwieser, Julian; Antonoglou, Ioannis; Lai, Matthew; Guez, Arthur; Lanctot, Marc; Sifre, Laurent; Kumaran, Dharshan; Graepel, Thore; Lillicrap, Timothy; Simonyan, Karen; Hassabis, Demis (5 December 2017). "Mastering Chess and Shogi by Self-Play with a General Reinforcement Learning Algorithm". arXiv:1712.01815 [cs.AI ].

- ^ Goodfellow, Ian; Pouget-Abadie, Jean; Mirza, Mehdi; Xu, Bing; Warde-Farley, David; Ozair, Sherjil; Courville, Aaron; Bengio, Yoshua (2014). Generative Adversarial Networks (PDF). Uluslararası Sinirsel Bilgi İşleme Sistemleri Konferansı Bildirileri (NIPS 2014). s. 2672–2680.

- ^ Zoph, Barret; Le, Quoc V. (4 November 2016). "Neural Architecture Search with Reinforcement Learning". arXiv:1611.01578 [cs.LG ].

- ^ "AutoKeras". autokeras.com. Alındı 21 Ağustos 2019.

- ^ "Claesen, Marc, and Bart De Moor. "Hyperparameter Search in Machine Learning." arXiv preprint arXiv:1502.02127 (2015)". arXiv:1502.02127. Bibcode:2015arXiv150202127C.

- ^ Turek, Fred D. (March 2007). "Introduction to Neural Net Machine Vision". Vision Systems Design. 12 (3). Alındı 5 Mart 2013.

- ^ Zissis, Dimitrios (October 2015). "A cloud based architecture capable of perceiving and predicting multiple vessel behaviour". Uygulamalı Yazılım Hesaplama. 35: 652–661. doi:10.1016/j.asoc.2015.07.002.

- ^ Roman M. Balabin; Ekaterina I. Lomakina (2009). "Neural network approach to quantum-chemistry data: Accurate prediction of density functional theory energies". J. Chem. Phys. 131 (7): 074104. Bibcode:2009JChPh.131g4104B. doi:10.1063/1.3206326. PMID 19708729.

- ^ Gümüş, David; et al. (2016). "Mastering the game of Go with deep neural networks and tree search" (PDF). Doğa. 529 (7587): 484–9. Bibcode:2016Natur.529..484S. doi:10.1038/nature16961. PMID 26819042. S2CID 515925.

- ^ Sengupta, Nandini; Sahidullah, Md; Saha, Goutam (August 2016). "Lung sound classification using cepstral-based statistical features". Biyoloji ve Tıp Alanında Bilgisayarlar. 75 (1): 118–129. doi:10.1016/j.compbiomed.2016.05.013. PMID 27286184.

- ^ Choy, Christopher B., et al. "3d-r2n2: A unified approach for single and multi-view 3d object reconstruction." European conference on computer vision. Springer, Cham, 2016.

- ^ French, Jordan (2016). "Zaman Yolcusunun CAPM'si". Yatırım Analistleri Dergisi. 46 (2): 81–96. doi:10.1080/10293523.2016.1255469. S2CID 157962452.

- ^ Schechner, Sam (15 June 2017). "Facebook Boosts A.I. to Block Terrorist Propaganda". Wall Street Journal. ISSN 0099-9660. Alındı 16 Haziran 2017.

- ^ Ganesan, N (2010). "Application of Neural Networks in Diagnosing Cancer Disease Using Demographic Data". International Journal of Computer Applications. 1 (26): 81–97. Bibcode:2010IJCA....1z..81G. doi:10.5120/476-783.

- ^ Bottaci, Leonardo (1997). "Artificial Neural Networks Applied to Outcome Prediction for Colorectal Cancer Patients in Separate Institutions" (PDF). Lancet. Neşter. 350 (9076): 469–72. doi:10.1016/S0140-6736(96)11196-X. PMID 9274582. S2CID 18182063. Arşivlenen orijinal (PDF) 23 Kasım 2018 tarihinde. Alındı 2 Mayıs 2012.

- ^ Alizadeh, Elaheh; Lyons, Samanthe M; Castle, Jordan M; Prasad, Ashok (2016). "Measuring systematic changes in invasive cancer cell shape using Zernike moments". Bütünleştirici Biyoloji. 8 (11): 1183–1193. doi:10.1039/C6IB00100A. PMID 27735002.

- ^ Lyons, Samanthe (2016). "Changes in cell shape are correlated with metastatic potential in murine". Biyoloji Açık. 5 (3): 289–299. doi:10.1242/bio.013409. PMC 4810736. PMID 26873952.

- ^ Nabian, Mohammad Amin; Meidani, Hadi (28 August 2017). "Deep Learning for Accelerated Reliability Analysis of Infrastructure Networks". Computer-Aided Civil and Infrastructure Engineering. 33 (6): 443–458. arXiv:1708.08551. Bibcode:2017arXiv170808551N. doi:10.1111/mice.12359. S2CID 36661983.

- ^ Nabian, Mohammad Amin; Meidani, Hadi (2018). "Accelerating Stochastic Assessment of Post-Earthquake Transportation Network Connectivity via Machine-Learning-Based Surrogates". Transportation Research Board 97th Annual Meeting.

- ^ Díaz, E.; Brotons, V.; Tomás, R. (September 2018). "Use of artificial neural networks to predict 3-D elastic settlement of foundations on soils with inclined bedrock". Soils and Foundations. 58 (6): 1414–1422. doi:10.1016/j.sandf.2018.08.001. hdl:10045/81208. ISSN 0038-0806.

- ^ null null (1 April 2000). "Artificial Neural Networks in Hydrology. I: Preliminary Concepts". Journal of Hydrologic Engineering. 5 (2): 115–123. CiteSeerX 10.1.1.127.3861. doi:10.1061/(ASCE)1084-0699(2000)5:2(115).

- ^ null null (1 April 2000). "Artificial Neural Networks in Hydrology. II: Hydrologic Applications". Journal of Hydrologic Engineering. 5 (2): 124–137. doi:10.1061/(ASCE)1084-0699(2000)5:2(124).

- ^ Peres, D. J.; Iuppa, C.; Cavallaro, L.; Cancelliere, A.; Foti, E. (1 October 2015). "Significant wave height record extension by neural networks and reanalysis wind data". Ocean Modelling. 94: 128–140. Bibcode:2015OcMod..94..128P. doi:10.1016/j.ocemod.2015.08.002.

- ^ Dwarakish, G. S.; Rakshith, Shetty; Natesan, Usha (2013). "Review on Applications of Neural Network in Coastal Engineering". Artificial Intelligent Systems and Machine Learning. 5 (7): 324–331.

- ^ Ermini, Leonardo; Catani, Filippo; Casagli, Nicola (1 March 2005). "Artificial Neural Networks applied to landslide susceptibility assessment". Jeomorfoloji. Geomorphological hazard and human impact in mountain environments. 66 (1): 327–343. Bibcode:2005Geomo..66..327E. doi:10.1016/j.geomorph.2004.09.025.

- ^ Nix, R.; Zhang, J. (May 2017). "Classification of Android apps and malware using deep neural networks". 2017 International Joint Conference on Neural Networks (IJCNN): 1871–1878. doi:10.1109/IJCNN.2017.7966078. ISBN 978-1-5090-6182-2. S2CID 8838479.

- ^ "Detecting Malicious URLs". The systems and networking group at UCSD. Arşivlenen orijinal on 14 July 2019. Alındı 15 Şubat 2019.

- ^ Homayoun, Sajad; Ahmadzadeh, Marzieh; Hashemi, Sattar; Dehghantanha, Ali; Khayami, Raouf (2018), Dehghantanha, Ali; Conti, Mauro; Dargahi, Tooska (eds.), "BoTShark: A Deep Learning Approach for Botnet Traffic Detection", Cyber Threat Intelligence, Advances in Information Security, Springer International Publishing, pp. 137–153, doi:10.1007/978-3-319-73951-9_7, ISBN 9783319739519

- ^ and (January 1994). "Bir sinir ağı ile kredi kartı dolandırıcılık tespiti". 1994 Yirmi Yedinci Hawaii Uluslararası Sistem Bilimleri Konferansı Bildirileri. 3: 621–630. doi:10.1109 / HICSS.1994.323314. ISBN 978-0-8186-5090-1. S2CID 13260377.

- ^ "AI, dünyamızı anlamak için önemli bir matematik bilmecesini çözdü". MIT Technology Review. Alındı 19 Kasım 2020.

- ^ Nagy, Alexandra (28 Haziran 2019). "Açık Kuantum Sistemleri için Sinir Ağı Ansatz ile Varyasyonel Kuantum Monte Carlo Yöntemi". Fiziksel İnceleme Mektupları. 122 (25): 250501. arXiv:1902.09483. Bibcode:2019PhRvL.122y0501N. doi:10.1103 / PhysRevLett.122.250501. PMID 31347886. S2CID 119074378.

- ^ Yoshioka, Nobuyuki; Hamazaki, Ryusuke (28 Haziran 2019). "Açık kuantum çok-cisim sistemleri için sinirsel durağan haller inşa etmek". Fiziksel İnceleme B. 99 (21): 214306. arXiv:1902.07006. Bibcode:2019arXiv190207006Y. doi:10.1103 / PhysRevB.99.214306. S2CID 119470636.

- ^ Hartmann, Michael J .; Carleo, Giuseppe (28 Haziran 2019). "Dağıtıcı Kuantum Çok-Vücut Dinamiklerine Sinir Ağı Yaklaşımı". Fiziksel İnceleme Mektupları. 122 (25): 250502. arXiv:1902.05131. Bibcode:2019arXiv190205131H. doi:10.1103 / PhysRevLett.122.250502. PMID 31347862. S2CID 119357494.

- ^ Vicentini, Filippo; Biella, Alberto; Regnault, Nicolas; Ciuti, Cristiano (28 Haziran 2019). "Açık Kuantum Sistemlerinde Durağan Durumlar için Varyasyonel Sinir Ağı Ansatz". Fiziksel İnceleme Mektupları. 122 (25): 250503. arXiv:1902.10104. Bibcode:2019arXiv190210104V. doi:10.1103 / PhysRevLett.122.250503. PMID 31347877. S2CID 119504484.

- ^ Forrest MD (Nisan 2015). "Ayrıntılı bir Purkinje nöron modeli ve 400 kat daha hızlı çalışan daha basit bir vekil model üzerinde alkol etkisinin simülasyonu". BMC Neuroscience. 16 (27): 27. doi:10.1186 / s12868-015-0162-6. PMC 4417229. PMID 25928094.

- ^ Siegelmann, H.T .; Sontag, E.D. (1991). "Sinir ağlarıyla hesaplanabilirliği döndürme" (PDF). Appl. Matematik. Mektup. 4 (6): 77–80. doi:10.1016 / 0893-9659 (91) 90080-F.

- ^ Balcázar, José (Temmuz 1997). "Yapay Sinir Ağlarının Hesaplamalı Gücü: Bir Kolmogorov Karmaşıklık Karakterizasyonu". Bilgi Teorisi Üzerine IEEE İşlemleri. 43 (4): 1175–1183. CiteSeerX 10.1.1.411.7782. doi:10.1109/18.605580.

- ^ a b MacKay, David, J.C. (2003). Bilgi Teorisi, Çıkarım ve Öğrenme Algoritmaları (PDF). Cambridge University Press. ISBN 9780521642989.CS1 bakimi: ref = harv (bağlantı)

- ^ Kapak, Thomas (1965). "Örüntü Tanıma Uygulamaları ile Doğrusal Eşitsizlik Sistemlerinin Geometrik ve İstatistiksel Özellikleri" (PDF). Elektronik Bilgisayarlarda IEEE İşlemleri. IEEE (3): 326–334. doi:10.1109 / PGEC.1965.264137.

- ^ Gerald, Friedland (2019). "Ses ve Multimedya Verilerinde Makine Öğrenimi için Yeniden Üretilebilirlik ve Deneysel Tasarım". MM '19: 27. ACM Uluslararası Multimedya Konferansı Bildirileri. ACM: 2709–2710. doi:10.1145/3343031.3350545. ISBN 9781450368896. S2CID 204837170.

- ^ "Tensorflow Ölçer".

- ^ Lee, Jaehoon; Xiao, Lechao; Schoenholz, Samuel S .; Bahri, Yasaman; Novak, Roman; Sohl-Dickstein, Jascha; Pennington, Jeffrey (15 Şubat 2018). "Her Derinlikteki Geniş Sinir Ağları, Gradyan İniş Altında Doğrusal Modeller Olarak Evrilir". arXiv:1902.06720. Alıntı dergisi gerektirir

| günlük =(Yardım Edin) - ^ [1], Sinir Tanjant Çekirdeği: Yapay Sinir Ağlarında Yakınsama ve Genelleme.

- ^ [2], Frekans Alanında Derin Sinir Ağının Eğitim Davranışı.

- ^ [3], Sinir Ağlarının Spektral Önyargısı Üzerine.

- ^ [4], Frekans İlkesi: Fourier Analizi Derin Sinir Ağlarına Işık Tutar.

- ^ [5], Genel Derin Sinir Ağları için Frekans İlkesi Teorisi.

- ^ Crick Francis (1989). "Sinir ağlarıyla ilgili son heyecan". Doğa. 337 (6203): 129–132. Bibcode:1989Natur.337..129C. doi:10.1038 / 337129a0. PMID 2911347. S2CID 5892527.

- ^ Adrian, Edward D. (1926). "Duyusal sinir uçlarının ürettiği dürtüler". Fizyoloji Dergisi. 61 (1): 49–72. doi:10.1113 / jphysiol.1926.sp002273. PMC 1514809. PMID 16993776.

- ^ Dewdney, A. K. (1 Nisan 1997). Evet, nötronumuz yok: kötü bilimin kıvrımları ve dönemeçleri arasında göz açıcı bir tur. Wiley. s. 82. ISBN 978-0-471-10806-1.

- ^ NASA - Dryden Uçuş Araştırma Merkezi - Haber Odası: Haber Bültenleri: NASA SİNİR AĞI PROJESİ KİLOMETRE TAŞIYOR. Nasa.gov. Erişim tarihi: 2013-11-20.

- ^ "Roger Bridgman'ın sinir ağlarını savunması". Arşivlenen orijinal 19 Mart 2012 tarihinde. Alındı 12 Temmuz 2010.

- ^ D. J. Felleman ve D. C. Van Essen, "Primat serebral korteksinde dağıtılmış hiyerarşik işlem," Beyin zarı, 1, s. 1-47, 1991.

- ^ J. Weng, "Doğal ve Yapay Zeka: Hesaplamalı Beyin-Zihnine Giriş, "BMI Basın, ISBN 978-0985875725, 2012.

- ^ a b Edwards, Chris (25 Haziran 2015). "Derin öğrenme için artan ağrılar". ACM'nin iletişimi. 58 (7): 14–16. doi:10.1145/2771283. S2CID 11026540.

- ^ "Evrişimli Sinir Ağları için FPGA tabanlı Hızlandırıcılara Yönelik Bir Araştırma ", NCAA, 2018

- ^ Cade Metz (18 Mayıs 2016). "Google, AI Robotlarını Güçlendirmek İçin Kendi Yongalarını Oluşturdu". Kablolu.

- ^ "{AI} - LISA - Yayınlar - Aigaion 2.0 için Öğrenme Algoritmalarını Ölçeklendirme". www.iro.umontreal.ca.

- ^ Güneş ve Kitapçı (1990)

- ^ Tahmasebi; Hezarkhani (2012). "Derece tahmini için hibrit sinir ağları-bulanık mantık-genetik algoritma". Bilgisayarlar ve Yerbilimleri. 42: 18–27. Bibcode:2012CG ..... 42 ... 18T. doi:10.1016 / j.cageo.2012.02.004. PMC 4268588. PMID 25540468.

Kaynakça

- Bhadeshia H.K.D.H (1999). "Malzeme Biliminde Sinir Ağları" (PDF). ISIJ Uluslararası. 39 (10): 966–979. doi:10.2355 / isijinternational.39.966.

- Bishop, Christopher M. (1995). Örüntü tanıma için sinir ağları. Clarendon Press. ISBN 978-0198538493. OCLC 33101074.

- Borgelt, Christian (2003). Neuro-Fuzzy-Systeme: von den Grundlagen künstlicher Neuronaler Netze zur Kopplung mit Fuzzy-Systemen. Görüntü. ISBN 9783528252656. OCLC 76538146.

- Cybenko, G.V. (2006). "Sigmoidal fonksiyonun Süperpozisyonları ile yaklaşıklık". Van Schuppen, Jan H. (ed.). Kontrol, Sinyaller ve Sistemlerin Matematiği. Springer Uluslararası. s. 303–314. PDF

- Dewdney, A. K. (1997). Evet, nötronumuz yok: kötü bilimin kıvrımları ve dönemeçleri arasında göz açıcı bir tur. New York: Wiley. ISBN 9780471108061. OCLC 35558945.

- Duda, Richard O .; Hart, Peter Elliot; Leylek, David G. (2001). Desen sınıflandırması (2 ed.). Wiley. ISBN 978-0471056690. OCLC 41347061.

- Egmont-Petersen, M .; de Ridder, D .; Handels, H. (2002). "Sinir ağları ile görüntü işleme - bir inceleme". Desen tanıma. 35 (10): 2279–2301. CiteSeerX 10.1.1.21.5444. doi:10.1016 / S0031-3203 (01) 00178-9.

- Fahlman, S .; Lebiere, C (1991). "Basamaklı-Korelasyonlu Öğrenme Mimarisi" (PDF).

- için yaratıldı Ulusal Bilim Vakfı, Sözleşme Numarası EET-8716324, ve Savunma İleri Araştırma Projeleri Ajansı (DOD), F33615-87-C-1499 Sözleşmesi uyarınca ARPA Sipariş No. 4976.

- Gurney Kevin (1997). Sinir ağlarına giriş. UCL Basın. ISBN 978-1857286731. OCLC 37875698.

- Haykin, Simon S. (1999). Sinir ağları: kapsamlı bir temel. Prentice Hall. ISBN 978-0132733502. OCLC 38908586.

- Hertz, J .; Palmer, Richard G .; Krogh, Anders S. (1991). Sinirsel hesaplama teorisine giriş. Addison-Wesley. ISBN 978-0201515602. OCLC 21522159.

- Bilgi teorisi, çıkarım ve öğrenme algoritmaları. Cambridge University Press. 25 Eylül 2003. Bibcode:2003itil.book ..... M. ISBN 9780521642989. OCLC 52377690.

- Kruse, Rudolf; Borgelt, Christian; Klawonn, F .; Moewes, Christian; Steinbrecher, Matthias; Düzenlendi, Pascal (2013). Hesaplamalı zeka: metodolojik bir giriş. Springer. ISBN 9781447150121. OCLC 837524179.

- Lawrence, Jeanette (1994). Sinir ağlarına giriş: tasarım, teori ve uygulamalar. California Scientific Software. ISBN 978-1883157005. OCLC 32179420.

- MacKay, David, J.C. (2003). Bilgi Teorisi, Çıkarım ve Öğrenme Algoritmaları (PDF). Cambridge University Press. ISBN 9780521642989.CS1 bakimi: ref = harv (bağlantı)

- Ustalar, Timothy (1994). Sinir ağları ile sinyal ve görüntü işleme: bir C ++ kaynak kitabı. J. Wiley. ISBN 978-0471049630. OCLC 29877717.

- Ripley, Brian D. (2007). Örüntü Tanıma ve Sinir Ağları. Cambridge University Press. ISBN 978-0-521-71770-0.

- Siegelmann, H.T .; Sontag, Eduardo D. (1994). "Sinir ağları aracılığıyla analog hesaplama". Teorik Bilgisayar Bilimleri. 131 (2): 331–360. doi:10.1016/0304-3975(94)90178-3. S2CID 2456483.

- Smith, Murray (1993). İstatistiksel modelleme için sinir ağları. Van Nostrand Reinhold. ISBN 978-0442013103. OCLC 27145760.

- Wasserman, Philip D. (1993). Sinir hesaplamada gelişmiş yöntemler. Van Nostrand Reinhold. ISBN 978-0442004613. OCLC 27429729.

- Wilson, Halsey (2018). Yapay zeka. Grey House Yayınları. ISBN 978-1682178676.

Dış bağlantılar

- Sinir Ağı Hayvanat Bahçesi - sinir ağı türlerinin bir derlemesi

- Stilwell Beyni - bir Zihin Alanı İnsanların, el yazısı rakamları sınıflandıran bir sinir ağında bireysel nöronlar gibi davrandığı bir deneyi içeren bölüm

![extstyle C=E[(x-f(x))^{2}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/2929ecb1606fdfeaddc55477d9671e11c034e21c)